Un peu de lecture concernant la gestuelle, dans la littérature, issue de la dernière conférence CHI 2011. Ces articles abordent trois thèmes en relation avec l’utilisation d’écran tactile et l’utilisation des gestes :

- La problématique de la détection ou non des gestes signifiants. Natural Activation for Gesture Recognition Systems Mathieu Hopmann. Frédéric Vexo, Patrick Salamin, Daniel Thalmann, Nicolas Chauvin.

- La performance lors de l’utilisation d’un téléphone mobile. Experimental Analysis of Touch-Screen Gesture Designs in Mobile Environments. Andrew Bragdon, Eugene Nelson, Yang Li and Ken Hinckley.

- Le dernier concerne l’accessibilité des interfaces gestuelles pour les malvoyants. Usable Gestures for Blind People: Understanding Preference and Performance. Shaun K. Kane, Jacob O. Wobbrock, Richard E. Ladner.

La problématique de la détection ou non des gestes signifiants.

Le résumé de l’article :

Gesture recognition is becoming a popular way of interaction, but still suffers of important drawbacks to be integrated in everyday life devices. One of these drawbacks is the activation of the recognition system – trigger gesture – which is generally tiring and unnatural. In this paper, we propose two natural solutions to easily activate the gesture interaction. The first one requires a single action from the user: grasping a remote control to start interacting. The second one is completely transparent for the user: the gesture system is only activated when the user’s gaze points to the screen, i.e. when s/he is looking at it. Our first evaluation with the 2 proposed solutions plus a default implementation suggests that the gaze estimation activation is efficient enough to remove the need of a trigger gesture in order to activate the recognition system.

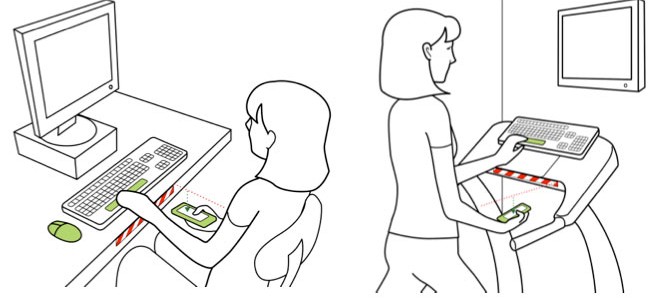

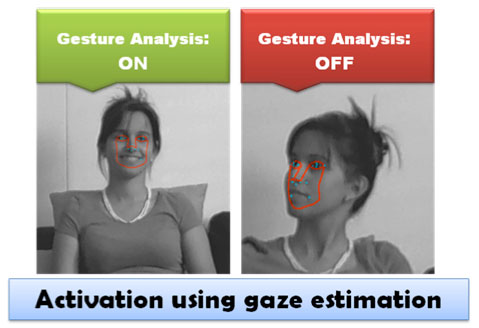

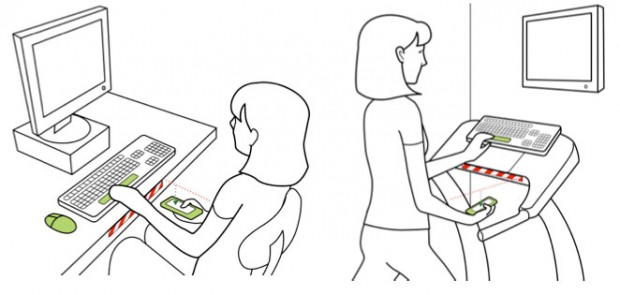

L’interaction sur la base de gestes est de plus en plus proposée dans un cadre ludique mais aussi pour d’autres usages sur la télévision. La difficulté est alors de faire le tri entre les gestes signifiants et les simples mouvements sans liens avec l’IHM. Cette recherche s’appuie sur trois moyens pour reconnaître les gestes signifiants :

- La prise en main de la télécommande.

- L’utilisateur doit regarder l’écran.

- L’utilisateur doit faire un geste spécifique pour activer le système. Dans le cadre de cet article, c’est « prendre la parole » en tendant la main vers l’écran.

Un test utilisateur est réalisé pour déterminer le système le plus pertinent pour les utilisateurs. Donc 12 utilisateurs sans connaissances particulières des interfaces gestuelles, passe une tâche relativement simple de sélection d’une chanson dans un coverflow. Les seules différences entre les tâches est le mode d’activation de l’interaction gestuelle et la position de la chanson (proche : tâche courte ; loin 8 à 12 chansons : tâche longue). En fin de tâche un questionnaire AttrakDiff est proposé aux utilisateurs afin de noter le coté hédonique et pragmatique de chaques systèmes.

En conclusion, les utilisateurs plébiscite l’activation avec le regard. Ils trouvent que prendre la télécommande et ne pas agir avec est assez contradictoire. L’usage du regard correspondrait mieux aussi à la situation relâchée que les utilisateurs ont chez eux devant la télévision.

La performance lors de l’utilisation d’un téléphone mobile.

Le résumé de l’article :

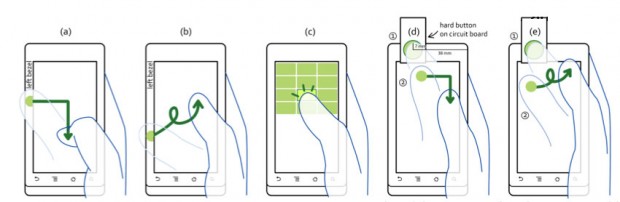

Direct-touch interaction on mobile phones revolves around screens that compete for visual attention with users‟ real- world tasks and activities. This paper investigates the impact of these situational impairments on touch-screen interaction. We probe several design factors for touch-screen gestures, under various levels of environmental demands on attention, in comparison to the status-quo approach of soft buttons. We find that in the presence of environmental distractions, ges- tures can offer significant performance gains and reduced attentional load, while performing as well as soft buttons when the user‟s attention is focused on the phone. In fact, the speed and accuracy of bezel gestures did not appear to be significantly affected by environment, and some gestures could be articulated eyes-free, with one hand. Bezel-initiated gestures offered the fastest performance, and mark-based gestures were the most accurate. Bezel-initiated marks there- fore may offer a promising approach for mobile touch-screen interaction that is less demanding of the user‟s attention.

Les smart phones à écran tactile ne dispose généralement pas de touches en dur, mais essentiellement de commandes à l’écran. L’hypothèse est donc que l’utilisation de ces commandes à l’écran est peu adapté dans un environnement comme le mobile où de nombreuses distractions viennent perturber l’utilisateur. Mais il est peut-être possible d’améliorer cela est combinant d’autres solution comme différents types de gestes.

Une expérimentation est mise en place pour tester cela. Elle croise différentes conditions d’utilisation plus au moins distrayantes avec des modes d’interactions différents.

Les résultats sont les suivants :

- Qui est le plus performant, geste ou commande à l’écran ? Lorsque les utilisateurs regardent l’écran, il n’y a pas de différences significatives. Dans les autres cas, les gestes sont plus performants.

- Comment l’attention est elle affecté par les gestes ? La performance est meilleur avec les gestes qu’avec les commandes à l’écran.

- Les gestes peuvent ils être réalisés sans regarder l’écran ? Les gestes peuvent être réalisé en regardant l’écran 3,5 % du temps contre 98,8 % pour les commandes à l’écran.

- Les gestes peuvent ils être réalisés d’une seule main ? Oui, mais dans le cas de certains gestes complexes, c’est réellement plus difficile.

- Comment les différents environnements affectent la vitesse et la précision des gestes ? Il apparaît les différents environnements n’ont aucun effet sur les gestes.

- Qu’est ce que les utilisateurs préfèrent ? Pour une utilisation en direct, seule 50 % des utilisateurs préfèrent les commandes à l’écran. Dans les autres cas, ils préfèrent les gestes.

Conclusion des gestes est pertinente dans les environnements perturbés et si l’utilisateur ne peut pas voir en permanence l’écran.

L’accessibilité des interfaces gestuelles pour les malvoyants.

Le résumé de l’article :

Despite growing awareness of the accessibility issues surrounding touch screen use by blind people, designers still face challenges when creating accessible touch screen interfaces. One major stumbling block is a lack of understanding about how blind people actually use touch screens. We conducted two user studies that compared how blind people and sighted people use touch screen gestures. First, we conducted a gesture elicitation study in which 10 blind and 10 sighted people invented gestures to perform common computing tasks on a tablet PC. We found that blind people have different gesture preferences than sighted people, including preferences for edge-based gestures and gestures that involve tapping virtual keys on a keyboard. Second, we conducted a performance study in which the same participants performed a set of reference gestures. We found significant differences in the speed, size, and shape of gestures performed by blind people versus those performed by sighted people. Our results suggest new design guidelines for accessible touch screen interfaces.

L’étude se compose de deux phases :

- Une première phase a pour but de mieux comprendre les interactions des personnes malvoyantes avec les interfaces tactiles.

- La deuxième phase permet de tester la performance pour différents types de gestes avec les personnes malvoyantes.

Lors de la première phase la tâche à réaliser est la suivante : L’expérimentateur demande aux participants d’inventer des gestes qui pourraient être utilisés pour exécuter un ensemble de commandes informatiques.

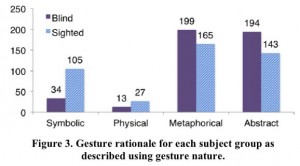

Les gestes ainsi inventés sont classés en 4 catégories : symbolique, physique, métaphorique et abstrait. Il est observé une différence significative entre les malvoyants et les voyants.

Pour la deuxième phase de l’étude, la procédure expérimentale est similaire à la première phase. Cependant, au lieu d’inventer de nouveaux gestes, les participants ont effectué des gestes indiqués par l’expérimentateur. Pour chaque geste, l’expérimentateur lisait le nom et une brève description du geste. Le participant essayait le geste une fois sur l’écran tactile. Puis l’utilisateur accomplissait trois fois le geste qui était enregistré. A la fin de chaque geste, le participant notait la facilité de réalisation du geste en utilisant une échelle «Le geste est facile à réaliser. » (1 = fortement en désaccord, 7 = entièrement d’accord). 40 gestes étaient testés, 3 fois avec 20 participants soit 2400 résultats.

En plus de la facilité d’utilisation d’autres paramètres étaient mesurés :

- La taille : plus grande pour les malvoyants;

- La variation de la taille pour le même utilisateur : plus de variation chez les malvoyants.

- Le rapport de la forme (hauteur/largeur) : Le rapport est même pour voyants et malvoyants, sauf certains gestes où les malvoyants ont tendances à faire des gestes plus larges.

- La vitesse : les voyants sont deux fois plus rapides que les malvoyants.

- La fermeture des formes : Sur un cercle, les malvoyants ont tendances à ne pas fermer le cercle.

- La rectitude des lignes : Sur un carré les lignes des voyants font moins de vagues que celles mal-voyants.

En conclusion, il est mis en évidence des différences significatives entre les malvoyants et les voyants dans l’usage des gestes aussi en terme de choix des gestes que dans la réalisation de ceux-ci.

- Les participants aveugles de l’étude ont montré une forte préférence pour les gestes qui utilisent les coins d’écran, les bords, et le multi-touch.

- Les gestes produit par les participants aveugles sont plus grands, plus lent, et présente une plus grande variation dans la taille que ceux produits par les participants voyants.

Encore beaucoup de choses à étudier sur les gestes !

Ces trois études montrent différents aspects des études actuellement réalisées sur les gestes et les écrans tactiles. Il existe encore de nombreux domaines à explorer afin de créer un corpus de connaissances sur ce type d’interactions de plus en plus présente dans la vie de tous les jours.