Lors de Parisweb 2025, j’ai donné cette conférence sur l’impact de l’IA sur nos métiers du numérique. Je vous propose donc la présentation et les notes associés, donc à peu près ce que j’ai raconté. La vidéo sera disponible bientôt.

Le fichier PDF L’impact de l’IA sur nos métiers du numériques (PDF, 4 mo)

Mes notes brutes :

- Donc, je vais vous parler de l’impact psychosocial de l’IA sur nos métiers du numérique

- Déjà, je vais me présenter brièvement, je travaille comme ux designer depuis le dernier millénaire. Personnellement, j’ai une formation initiale en psychologie sociale et en ergonomie, d’où le fait que je vais parler des risques psychosociaux liés à l’intelligence artificielle.

- Au début, je ne voulais pas parler de l’IA, car ça a toutes les caractéristiques d’une technologie zombie :

- Ce n’est pas nouveau, c’est des technos qui existent depuis les années 60.

- Ça buzz de temps en temps, quand il y a un changement de techno, puis ça disparait.

- C’est une technologie qui n’est pas viable dans le monde fini que nous habitons. Donc il y a un moment ou il va falloir choisir entre conduire des SUVs électrique ou utiliser l’iA. Les deux consomment les même ressources, de l’electricité et des terres rares.

- Donc je reste persuadé que c’est une bulle qui va éclater, mais en attendant ça un impact sur nos métiers, nos organisations. J’ai donc essayé de trouver quelques études pour regarder ce que ça donne. Pour l’instant elles sont assez peu nombreuses.

- Avant d’attaquer avec nos métiers, je vous propose un pas de côté dans un métier où l’IA est déjà bien implanté depuis un certain temps.

- Donc, je vous propose de commencer par une étude ergonomique par Tamari Gamkrelidze, La mise en œuvre de l’IA dans un service de radiologie. Deux usages de l’IA sont faits : la détection automatique des fractures sur les radios et la reconnaissance vocale pour la transcription des comptes rendus.

- Impacts : Les secrétaires médicales ne retranscrivent plus les comptes-rendus oraux de médecins, c’est automatisé, mais c’est au médecin de vérifier l’exactitude de la retranscription. Cette étape de transcription va donc être “supervisé” par le médecin au lieu d’être faite par les secrétaires.

- Pour la reconnaissance vocale, en positif, on note le gain de temps dans la production.

En négatif, un appauvrissement du rôle de la secrétaire qui ne relie plus les comptes rendus et pouvaient éviter des erreurs aux radiologues. - En positif, la détection joue un rôle de vérification et peut guider notamment les internes. Mais ce guidage à des conséquences négatives si on s’appuie trop dessus, notamment dans l’apprentissage, et risque de lui faire trop confiance et de passer à côté de fractures “atypiques” mal détectées.

- Moins de coopérations, moins de contrôles, plus d’erreurs et Trop d’assistance ralentie les apprentissages

- On va, maintenant, aborder un premier aspect qui concerne le consentement…

- Qui utilise l’IA dans son travail, de manière régulière hors test ?

- Qui est contraint d’utiliser l’IA ?

- Qui est content d’utiliser l’IA ?

- Qui est content d’utiliser l’IA, mais n’ose pas lever la main ? (Pour ceux qui n’ont pas oser répondre, venez me voir on va monter un groupe de parole pour les IA anonymes )

- Pas besoin de faire un dessin, vous l’avez vu vous-même. Il y a de l’IA qui nous est fourguée dans tous nos outils, que ça soit pour nos usages pros, ou même les outils du quotidien. Bien sûr, on ne nous a pas demandé si on en voulait ou pas. Au mieux, on vous laisse le choix de ne pas partager votre travail pour que ça soit digéré par une IA.

- Il y a aussi un impensé sur l’IA. Une injonction a utilisé l’IA, on ne sait pas trop pourquoi faire ? Mais une injonction à l’intégrer dans nos métiers, sans qu’il y ait un besoin qui ait émergé de nos pratiques. Voir ça crée une concurrence malsaine entre collègue, y ‘en un qui commence à l’utiliser puis l’autre est obligé de suivre. Une espèce de FOMO (fear of missing out) vis-à-vis de l’IA. Une peur de passer à coté.

- Et ça commence par le recrutement. Et en fait il y a déjà un vrai risque sur la phase de recrutement avec le traitement automatisé de ceux-ci. Il n’y a pas ou peu de contrôle sur ces outils destinés au ressources humaines. Le constat qui est fait, c’est que ça amplifie les discriminations. Et les entreprises se cachent derrière l’outil pour ne pas assumer leurs responsabilités.

- La réalité est déjà, Albert, l’IA de l’état, pourrait servir à organiser les affectations de poste et pour éviter les conflits. Je vous laisse imaginer les conséquences de l’usage d’un algorithme dans ces conditions.

- J’ai un peu trainé dans des conférences agiles ces derniers temps et ce qu’on proposait comme futur “désirable” ça ressemblait à ça : un backlog trié par IA, avec une attribution automatique et une évaluation de la complexité, comme ça, on est sûr vous ne glandez pas dans un coin et on surveille votre productivité.

- Donc, je vous pose la question, vous consentez à ce que votre travail soit organisé avec votre équipe ou par une intelligence artificielle.

- Le grand argument de l’IA c’est aussi la productivité… vous allez gagner du temps … (ou pas)

- Très bien gagner du temps. Alors, quand j’ai commencé à travailler comme ergonome IHM à l’époque, j’ai un mentor qui m’a dit “Si tu conçois un logiciel qui permet de faire le travail deux fois plus vite, combien il restera d’utilisateurs dans 6 mois ? Probablement deux fois moins, mais si on peut se trouver l’excuse qu’ils ont avoir à faire des choses plus intéressantes ? Oui, mais quoi ? Un traducteur va faire quoi de plus intéressant que de traduire ?

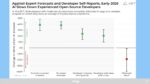

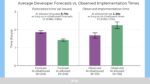

- Alors, je vous propose de vous pencher sur une expérience récente. Des chercheurs ont demandé à 19 développeurs expérimentés de soumettre un certain nombre de tâches de développement classiques plus de 250 au total. Puis ils ont redistribué ses tâches aux autres développeurs et ils ont demandé une estimation du temps nécessaire pour faire la tâche avec ou sans IA et puis de réaliser la tache.

- Brièvement, ce qui en ressort, c’est que les développeurs estiment le temps gagné avec l’IA à 20% alors qu’en réalité ils mettent 20% de temps en plus ! Et ils maintiennent cette estimation même après avoir vu les résultats de l’étude. Une autre fois je vous parlerai des biais de confirmation !

- Si on regarde dans le détail, sans IA, le temps estimé est assez proche du temps observé de réalisation de la tâche. Avec IA, le temps estimé est largement inférieur au temps sans IA, mais surtout, il est largement inférieur au temps réel observé.

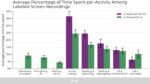

- Qu’est-ce qui change entre les deux situations ? En fait les développeurs sous-estiment complètement le temps qu’ils passent à interroger l’IA, à attendre qu’elle réponde et à relire le code fourni. Donc ça fait gagner un peu de temps de code, sur la lecture de la documentation et les tests, mais pas assez pour compenser le temps perdu avec l’IA.

- Donc vous préférez : passer du temps à écrire du code propre, de qualité, documenté et maintenable ou corriger du code de piètre qualité produit par une IA et dont vous n’avez aucune idée de la manière dont il fonctionne ?

- On la vue dans le cas de radiologie, un des risques c’est l’expertise, comment l’acquérir et la maintenir…

- Qu’est qui fait la différence entre un novice et un expert : C’est les métaconnaissances, c’est-à-dire les connaissances sur les connaissances. La capacité à développer de nouvelles connaissances, de nouvelles procédures. Bien sûr si vous prenez une IA, elle n’a aucune connaissance et encore moins des métaconnaissances. Elle a juste des données. On y reviendra.

- Donc l’expertise, dans la vraie vie, ça s’acquiert par, l’apprentissage, pour dessiner un personnage, on apprend les proportions, et l’anatomie. (C’est qu’une IA générative ne connaît pas), l’expérience de l’imitation quand on est bébé à l’expérience pro. La collaboration avec ses collègues : Pour résoudre un problème, vous préférez demander à collègue ou à une intelligence artificielle ? Et bien sûr la transmission de ces connaissances…

- Et donc le risque identifier est double, moins d’interactions au sein des équipes avec toutes les conséquences que ça peut avoir sur l’ambiance et des difficultés pour les novices à passer certains seuils de compréhension sans recourir à l’expertise de leurs pairs.

- Donc vous préférez, partager vos connaissances entre humains ? Ou éduquer des intelligences artificielles ?

- On va parler aussi un peu de Design

- Alors, petit rappel, l’IA c’est comme dans CIA, la CIA, ce n’est pas l’agence centrale de l’intelligence, mais du renseignement. En France on parle des renseignements généraux. Pas d’intelligence générale, ça se serait… Donc l’IA n’est pas intelligente, mais a des données liées entre elles par un modèle probabiliste.

- Il faut bien comprendre que, derrière toutes les intelligences artificielles, il y a un réseau de neurones. Ce n’est absolument pas nouveau, ça date des débuts de l’informatique dans les années 60. Chaque neurone va avoir des valeurs en entrée qu’il va pondérer pour donner le résultat le plus probable. Cela, maintenant dans des proportions gigantesques. Donc, par conception, ces modèles sont bons voir très bon quand ils sont dans la zone “médiane”. Plus on s’éloigne de cette zone médiane, moins les résultats vont être bons ou pertinents, plus ça risque d’halluciner. Donc l’IA est performante pour aller d’un domaine connu à un autre, de l’oral au texte, d’une langue à une autre. Elle est performante pour distinguer et classer des schémas connus : détecter des cancers sur des radios (6,7 avec IA pour 5,7 /1000 femmes cancers du sein) Classer des commentaires.

- Elle est aussi très performante pour vous refourguer des stéréotypes et des biais. Donc, quand je vois des designers qui se servent de l’IA pour explorer des pistes créatives, non, ce n’est pas des pistes, c’est des autoroutes ! Une fois sur ces autoroutes, ça être très difficiles d’en sortir.

- J’avais croisé ce post sur LinkedIn (oui, je sais c’est mal de perdre son temps sur LinkedIn). Concrètement si on traduit, ça veut dire j’écris un cahier des charges exhaustif pour chacune des pages et ça me produit les maquettes ou mieux le logiciel… Sauf que écrire un cahier des charges exhaustif, c’est qu’on faisait au dernier millénaire et aujourd’hui c’est n’est pas très agile. Donc, perso, je ne rêve pas d’écrire des cahiers charges, je préfère aller taper la discute avec des utilisateurs ou dessiner des écrans.

- (même slide que la précédente)

- donc concrètement à quoi ça peut servir dans un processus de design ?

- Ce qui marche bien, en gros c’est qui tourne autour du langage écrit ou oral. Petit point d’attention, les fonctions de résumés, de synthéses vont négligé les signaux faibles qui nous intéresse.

- Donc ce qui ne marche pas :

- Pour la stratégie UX, si vous demandez à Chat gpt, ça va vous sorti un processus bateau, donc si vous êtes un peu expert… bah c’est poubelle.

- Pour faire l’état de l’art ? Perplexity est fiable à 50% donc là c’est juste mort, faite une recherche dans une bibliothèque en ligne (Cairn ou ACM), ça sera plus sur.

- Pour le design UI, faites un petit exercice demander à une IA de générer un logo, puis faits une recherche par image dans google avec le logo généré. Grosse rigolade en perspective.

- Pour l’étape des maquettes, le résultat est niveau débutant, et en plus, ça ne respecte pas les bonnes pratiques en terme de composants et d’organisation du fichier. Soit tu écris un cahier des charges,

- La mesure de l’UX, c’est des méthodes précises qui ne laissent pas de place aux aléas, donc si tu ne sais pas, tu ouvres le livre de Carine Lallemand Méthodes de design UX

- Alors, non, ce n’est pas parce que tu prends des décisions, mais c’est parce que tu essayes d’expliquer ton métier à un système qui n’apprend rien et qui interprète de façon aléatoire tes demandes. Même un étudiant en première année ferait mieux !

- Pour en revenir aux risques psychosociaux qu’on peut identifier. Pour moi il y a le risque de la médiocrité, de la rapidité qui ne va pas laisser le temps nécessaire à la maturation d’une bonne idée. Perso, mes meilleurs idées, je les ai en courant dans la montagne pas dans un ordi. Donc ça va entrainer une lassitude cognitive, en épuisement plus rapide, et l’absence de construction des méta-connaissances vu qu’il y a absence de réflexion, d’essai-erreur. Deuxième point, quand vous adressez à une IA pour « challenger » une idée, vous ne vous adressez pas à des humains, pas des experts d’un métiers que soit des développeurs ou des juristes. Donc perte de lien avec les collègues… Et donc aussi probablement une moindre prise en compte des utilisateurs finaux, vous savez le U de UX et donc une perte de sens, de valeur.

- Parlons maintenant d’un futur désirable pour nos métiers…

- Donc, si on veut un futur désirable pour nos métiers, j’aurai quelques propositions à vous faire :

- Limiter l’usage aux tâches chronophages ! : Transcription, Sous-titrage (et l’accessibilité), reconnaissance d’écriture (oui les post-its à saisir) ou la classification de contenus

- Préférer les petits modèles spécialisés : Langage, Détection, optimisation, en appui à une expertise humaine

- Vérifier les résultats, vous connaissez le départ et l’arrivée : Dont on connaît le domaine de départ et celui d’arrivée

- faite tourner ça sur votre ordi ! : Et pas sur celui de quelqu’un d’autre dans les nuages !

- Le risque est réel, notamment sur l’apprentissage et le transmission de connaissance. Il y a un risque de perte de sens dans nos activités et donc une lassitude qui peut arriver plus rapidement d’où la nécessité de prendre soin de nous et de nos relations aux autres.

- Si vous voulez aller plus loin, ou avoir des arguments pour convaincre dans votre entreprise, vous pouvez aussi vous appuyez sur ces deux guides qui montrent de bonnes pratiques autour de l’IA.

- Une dernière citation tirée de Dune, un petit livre de science-fiction écrit par un humain.

- Merci.